自建对比官网的优点,官网目前动不动就服务器繁忙,体验很差,使用官方api也是如此,自建没有此问题,但是自建对于硬件要求比较高,配置较低的话,只能使用较低的模型,体验很是很差,主要是折腾着玩吧。

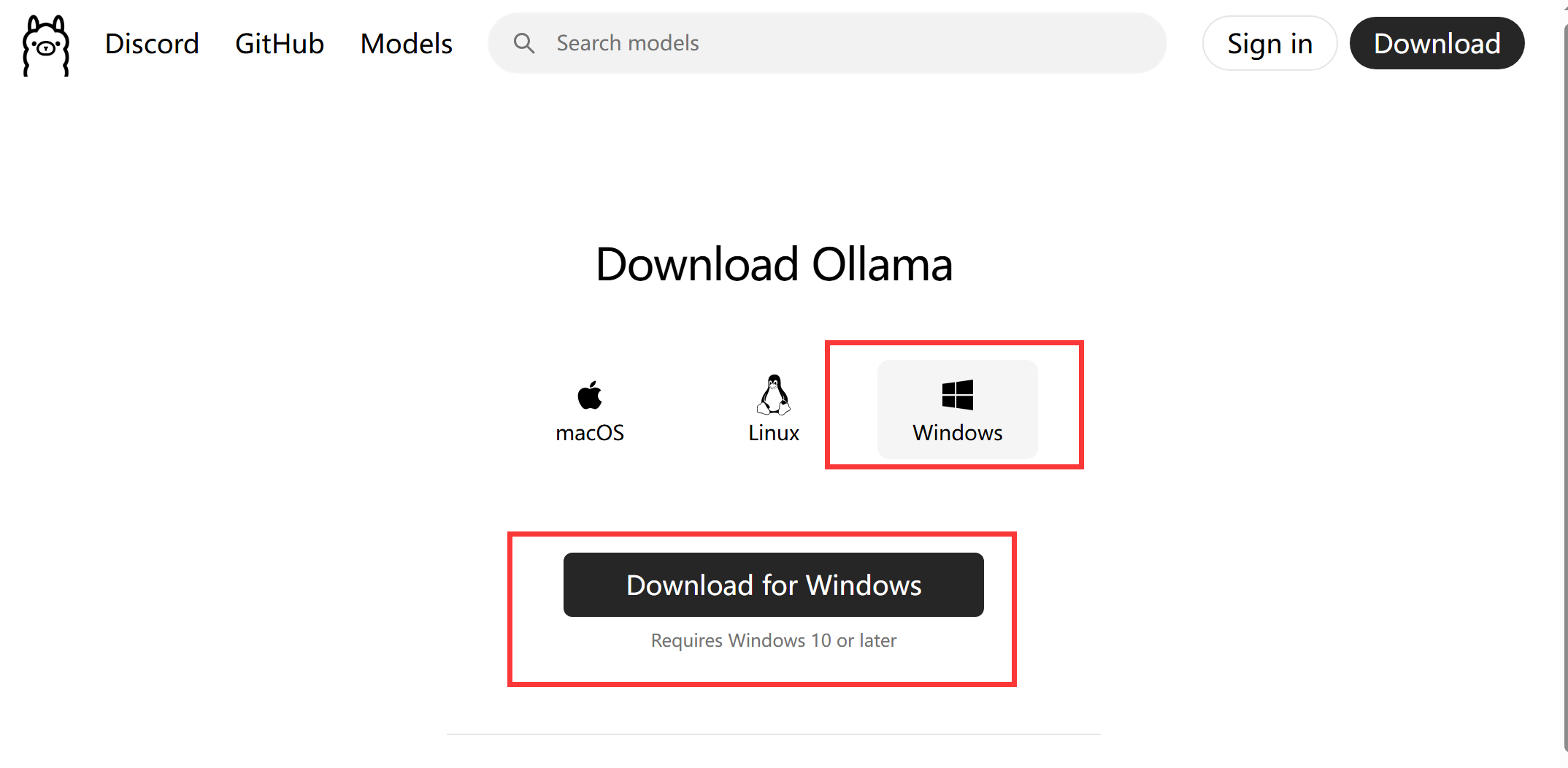

1、下载安装ollama

windows直接点击进官网,点击下载,然后跟着步骤安装就可以

linux系统下,输入以下命令,自动安装

curl -fsSL https://ollama.com/install.sh | sh2、安装DEEPSEEK

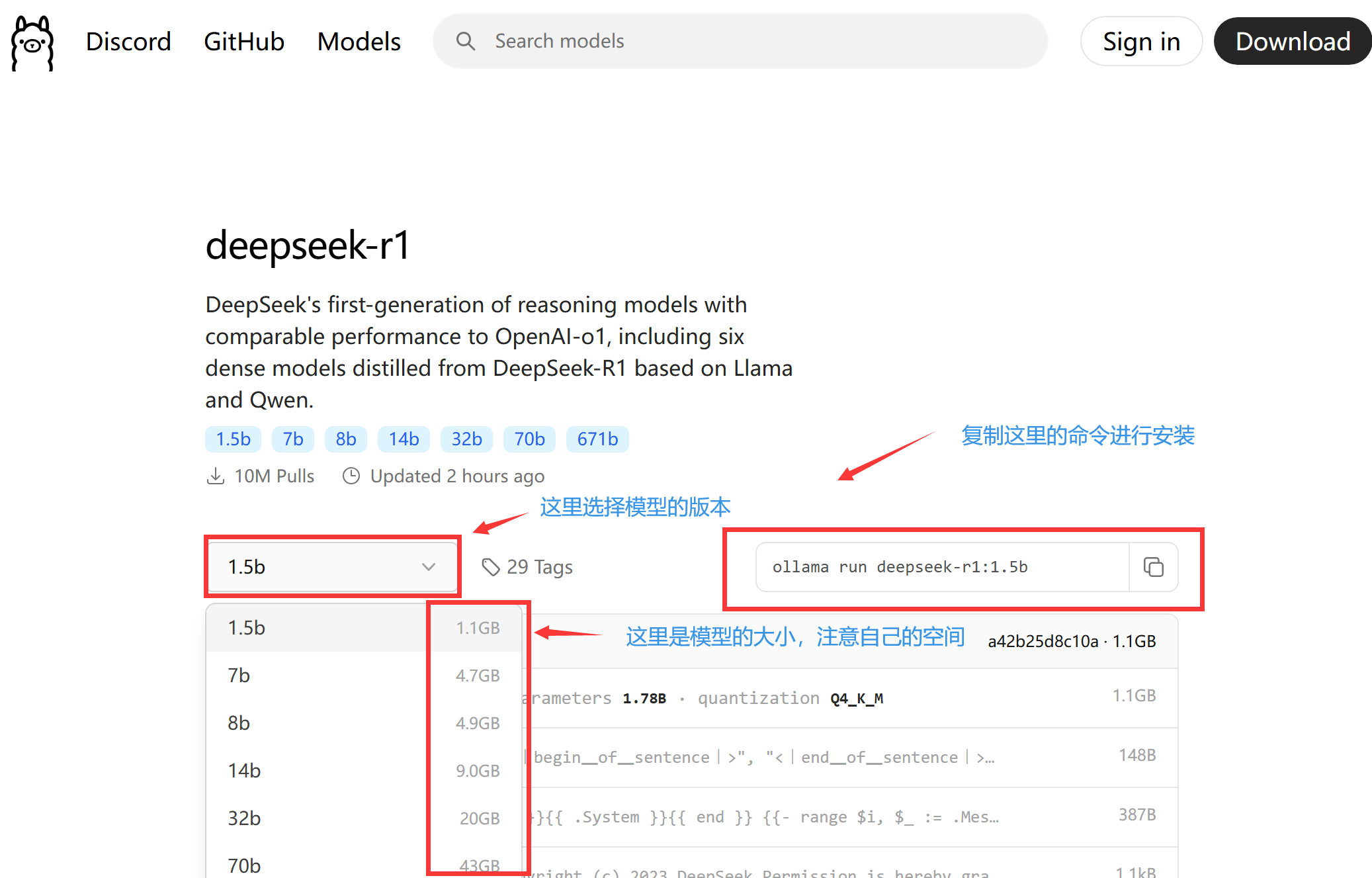

我们进入DEEPSEEK模型的网址,按照图片进行操作,这里我们以安装deepseek-r1:1.5b举例

windows

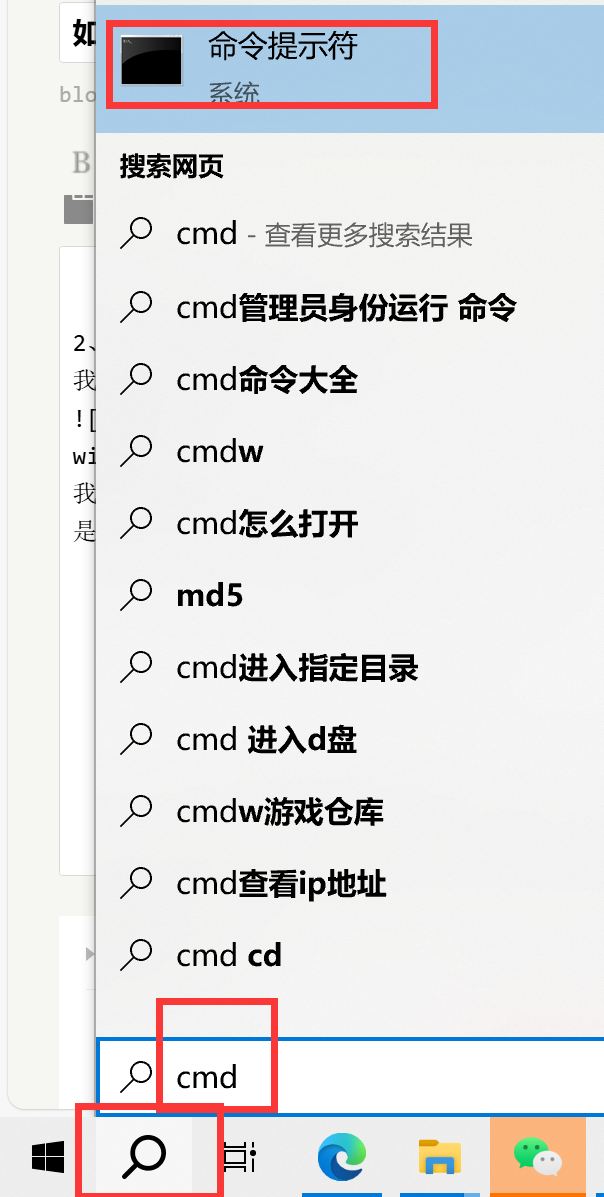

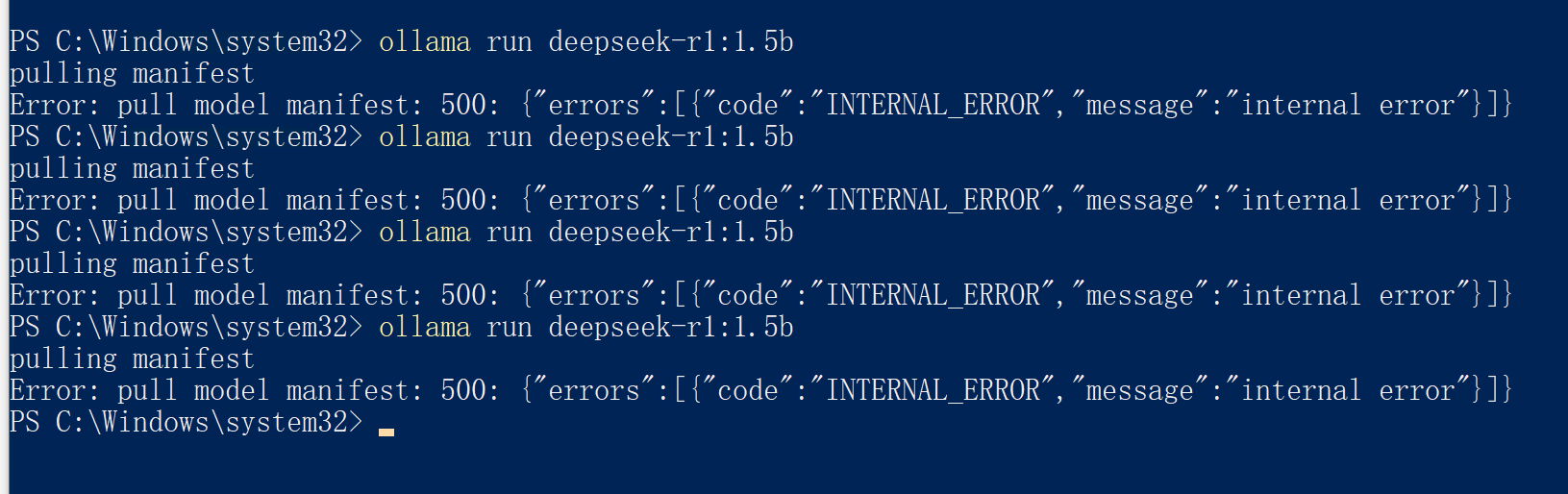

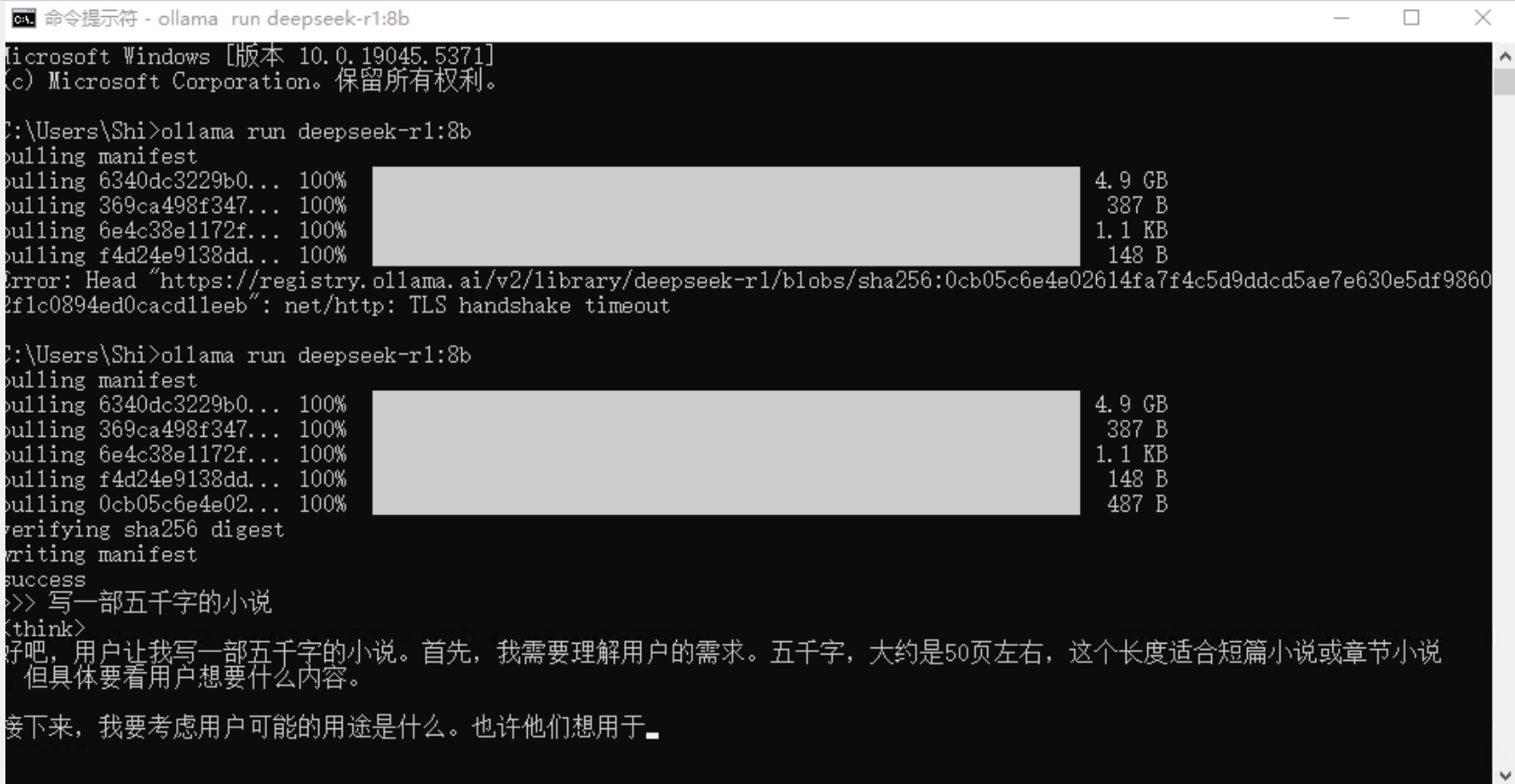

我们点击搜索选项,输入cmd,然后点击命令提示符,之后在里面输入以下代码,代码参考图片获取,代码运行可能会出现图片中的报错,可能是网络原因,多尝试几次就可以了,再命令提示符里,直接点击鼠标右键,就可以粘贴复制的东西。

ollama run deepseek-r1:1.5b

linux

linux直接输入下面的命令就可以

ollama run deepseek-r1:1.5b

安装完成会进入以下界面,然后在命令提示符里面和deepseek进行对话,如果关闭命令提示符后,想继续和deepseek对话,重新进入命令提示符,然后在运行当时安装deepseek的命令,就可以进入对话界面了

ollama run deepseek-r1:1.5b

3、设置deepseek可以跨机器使用

默认安装的deepseek只能在本机连接,无法通过其他机器或者远程连接,这里我们需要进行一下设置,如果需要外网链接,这里需要路由器或者光猫进行端口转发,端口转发这里不设教程。

3.1更改ollama监听端口,让其他客户端可以远程访问本地的ollama

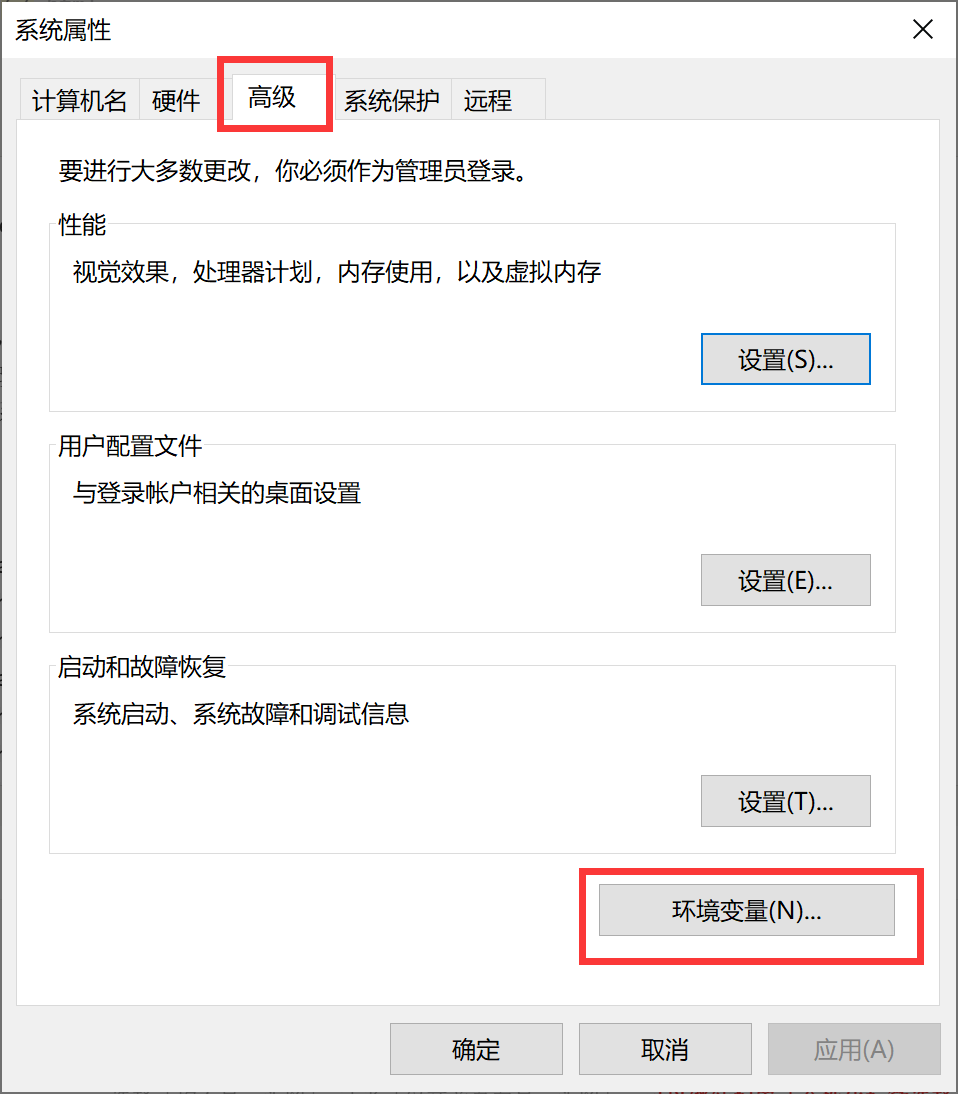

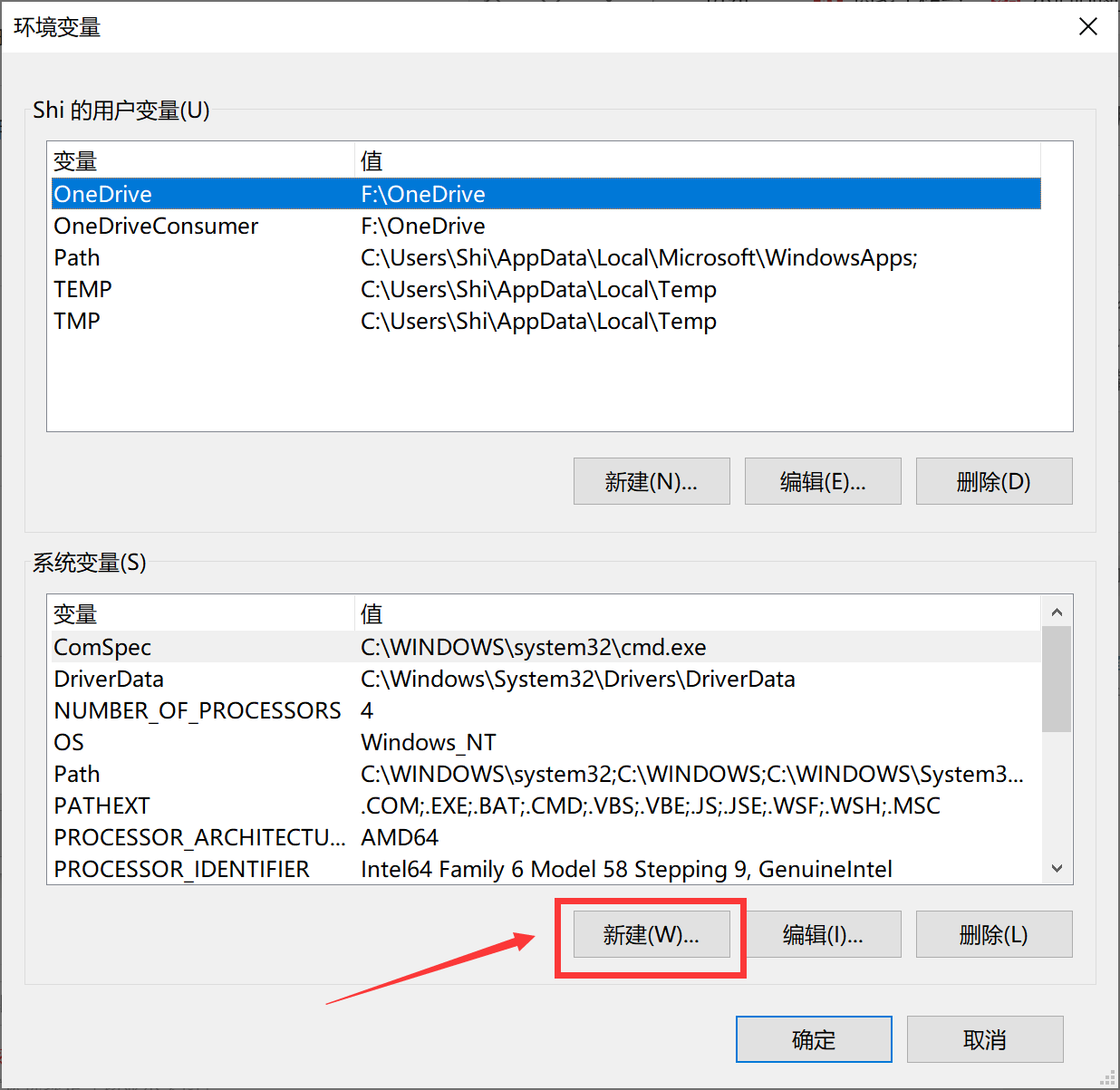

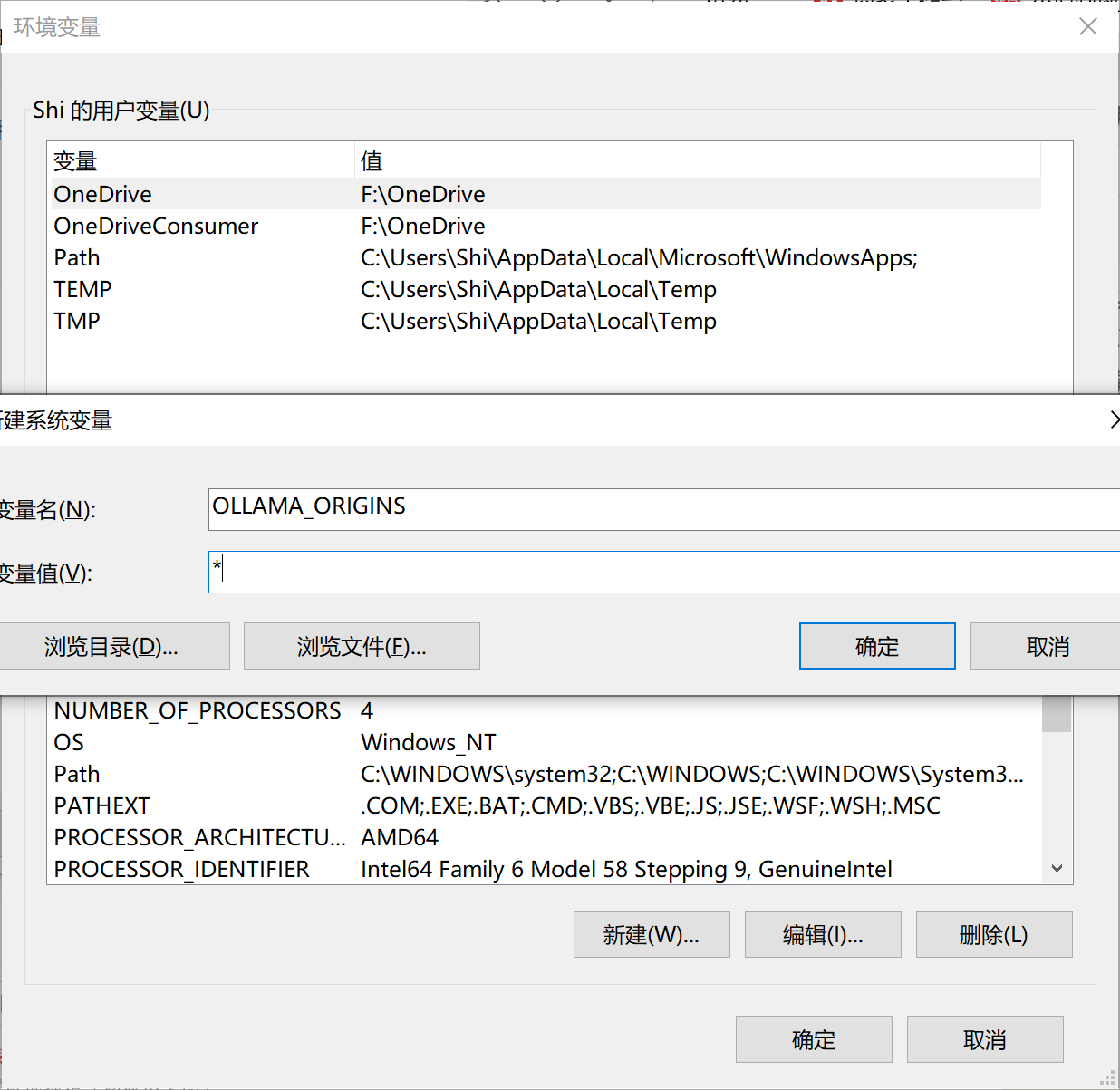

windows系统我们通过更改系统变量解决

在搜索栏里面,我们搜索系统变量,然后打开编辑系统变量,之后点击环境变量,在系统变量里面点击新建,输入变量名称:OLLAMA_HOST,变量值0.0.0.0,点击确定,然后再次在系统变量里面点击新建,输入变量名称:OLLAMA_ORIGINS,变量值:*,点击确定,然后重启电脑就可以了。

在linux里面里面,我们输入以下命令

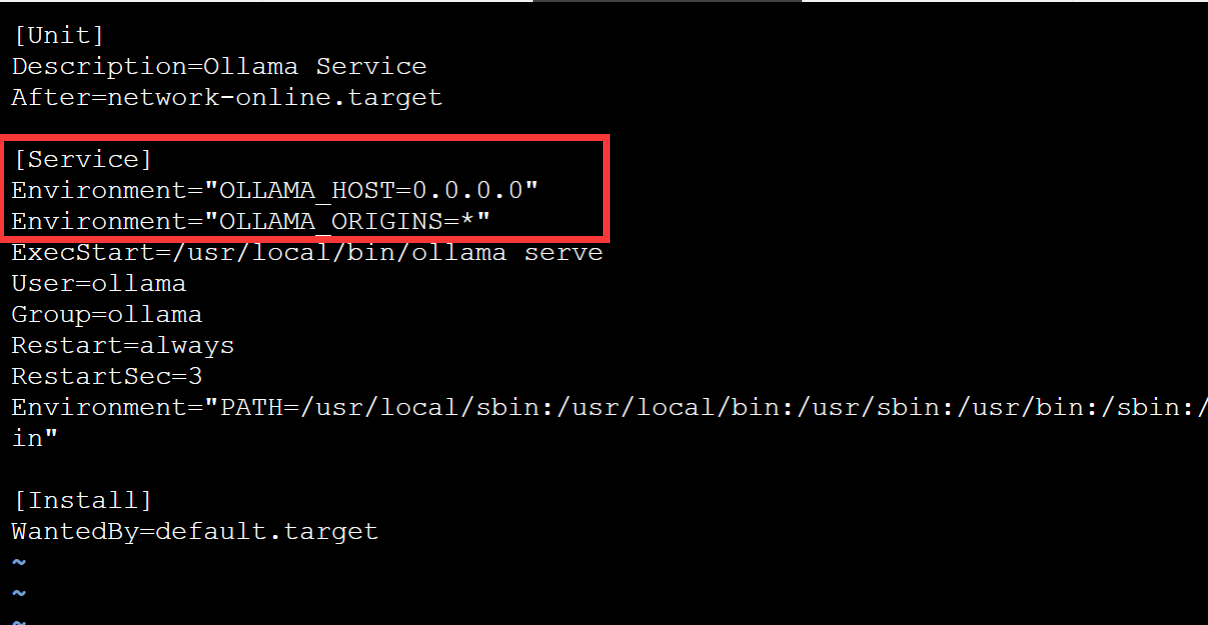

vi /etc/systemd/system/ollama.service之后,我们将光标移动到[Service]下方,然后输入i,然后将下面文本粘贴上去,

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

之后按esc键,然后输入:wq保存文件,修改好的文件如图

最后我们输入命令重启一下

systemctl daemon-reload

systemctl restart ollama3.2使用浏览器插件链接自建的deepseek

这里感谢空美和X佬推荐

浏览器插件需要特殊的方式访问,请自行解决

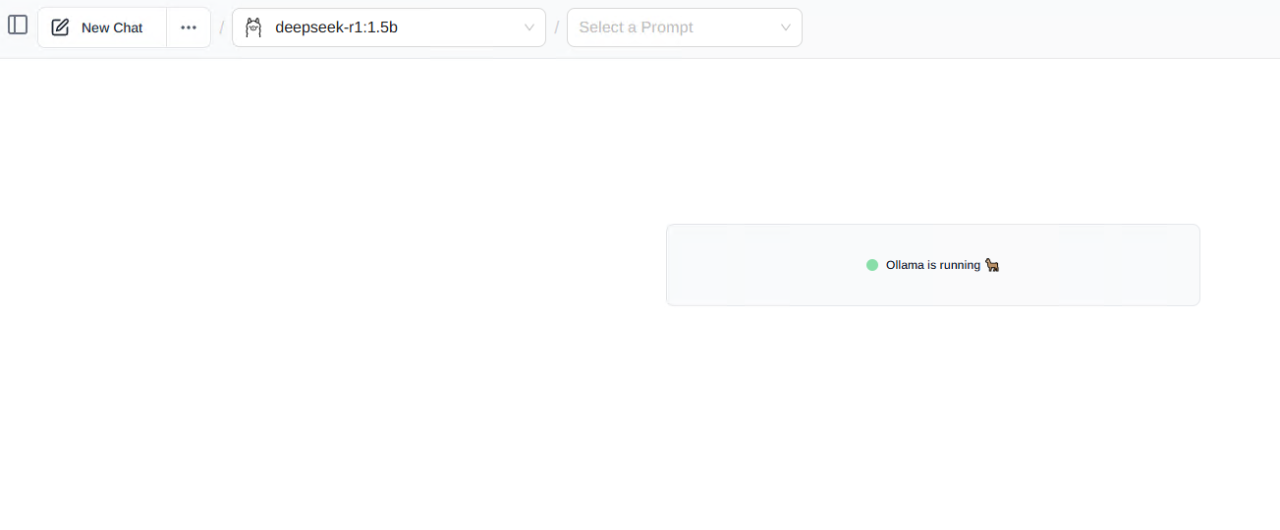

插件名为Page Assist,谷歌浏览器和edge浏览器点击这里使用,火狐浏览器点击这里使用,火狐浏览器不需要特殊的访问手段。

进入浏览器如果是本机访问,会自动连接deepseek,如果非本机访问,就输入deepseek所在机器的ip:11434,即可链接deepseek进行对话

3.3使用自建open-webui连接deepseek

参考:

1、Windows安装与配置Ollama

2、linux服务器部署deepseek R1及远程连接

3、最全的DeepSeek访问以及使用方法

4 条评论

口大你现在什么配置,搞的啥模型

1581,32G能搞,就是一个字一个字的崩,8b差不多,962显卡

这个一般电脑都带动不了满血版吧

再大胆点,基本上所有的家用电脑,都带不动满血版,搞个1.5b,8b就差不多了。